In un panorama digitale in rapidissima trasformazione, è importante mantenere un’elevata attenzione ai temi della sicurezza ed essere in grado di rispondere alle sfide di Oggi pensando a quelle di Domani. Nel pomeriggio del Cybersecurity Summit 2022, lo scorso 18 ottobre a Roma, sono stati trattati i diversi aspetti legati al ridisegno dell’architettura di sicurezza nei settori delle infrastrutture critiche nazionali, alla luce di una Trasformazione Digitale accelerata dalla pandemia e dalla crisi internazionale (QUI invece i temi della mattinata).

Quindi: come mettere in sicurezza il cloud, le reti, i dispositivi connessi; la sicurezza degli ambienti IoT e della supply chain; come ottimizzare Detection & Incident Response e prepararsi a un attacco ransomware; cybersecurity e intelligenza artificiale per ridurre i tempi della detection e della risposta; come ripensare identità digitale e innovazione Zero Trust degli approcci IAM; il futuro del SOC nell’era dell’AI e dei big data.

“Abbiamo sentito parlare di digitale con molte formule, ma va considerato oggi che le infrastrutture critiche possono avere impatto su cittadini, stato, collettività – ha detto Francesco Di Maio, Head of Security Department di Enav, aprendo i lavori del pomeriggio -. Oggi abbiamo il dovere della salvaguardia del business, con tutte le conseguenze connesse, anche nei confronti della collettività. Abbiamo un dovere giuridico di protezione di interessi collettivi. Aggiungiamo che il framework normativo che si sta propagando sulle imprese avrà sempre di più questo fine”.

Come deve cambiare il mindset e come trasformare i processi operativi con particolare attenzione a terze parti e alla collaborazione? “Le organizzazioni devono rompere i silos – ha aggiunto Francesco Di Maio -, avere la possibilità di costruire un approccio al rischio sempre più olistico e integrato: questo cambia il mindset. Bisogna intercettare esattamente elementi critici della catena di produzione, catena del valore e terze parti. Ricordarsi che la tecnologia non ci salva: servono processi fortemente orientati al business, responsivi della necessità di limitare il rischio di cybersecurity”.

Come fare in modo che l’organizzazione accresca postura e capacità di prevenire e gestire attacchi e minacce? E concretamente, quali sono le azioni prioritarie da mettere in campo per la protezione di persone, infrastrutture, applicazioni, dati e dispositivi connessi?

Secondo Nicla Ivana Diomede, Direttore Dipartimento Cybersecurity e Sicurezza di Roma Capitale, il primo step è quello di farsi delle domande e decidere quale strategia perseguire come organizzazione. “La strategia ci consente di ingaggiare i vertici e renderli partecipi, averne l’endorsement per le risorse e ripensare ruoli e responsabilità, oltre che i processi sottostanti – ha detto Nicla Ivana Diomede –. Abbinare tecnologie, processi e persone è facilitato se si ha definito una strategia unitaria. Bisogna capire da dove si parte, analizzare la propria postura con carotaggi specifici, capire come sono gestiti i singoli processi: solo così si possono costruire piani di potenziamento, individuare gli interventi più premianti, definire evoluzione a breve, medio e lungo termine”.

Un approccio sostenibile sarà quindi basato su partecipazione e condivisione: solo così si potrà raggiungere un buon risultato. “Il CISO ha il compito di comunicare gli obiettivi e di motivare le persone a far propria questa missione – ha aggiunto Diomede -. Negli ultimi due anni c’è stata un’accelerazione su questo fronte: a livello di management questa attenzione oggi c’è. Per quanto riguarda le persone, l’approccio è cambiato, c’è ancora un po’ di ingenuità. Importante che la funzione di cybersecurity interagisca con il resto dell’organizzazione per spingere una sensibilità diffusa, in ottica preventiva”.

Cosa significa oggi lavorare sul fattore umano? “Un conto è fare formazione, altra cosa è l’obiettivo ambizioso di trasformare i comportamenti – ha spiegato Vittorio Bitteleri, Country Manager Italia di Cyber Guru -. I comportamenti umani sono l’anello debole della cybersecurity, nel 90% dei casi un cyber attacco inizia con un errore inconsapevole dell’utente. Noi abbiamo messo a terra, tramite un team multidisciplinare, una metodologia che, ponendo al centro gli individui, va a declinare concetti come gamification, comunicazione multimediale, velocità nell’erogazione dei contenuti, ripetizione di informazioni per aumentare la consapevolezza. Poi, portiamo i discenti a immedesimarsi, tramite storie di vita normale, dove a fronte di comportamenti molto comuni (come collegarsi a wifi pubblico) il finale è funesto”.

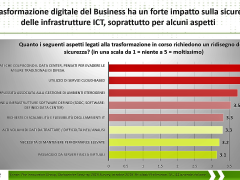

La trasformazione digitale cambia l’esperienza dei clienti e genera volumi crescenti di informazioni che sono un valore per le aziende e per tutti gli stakeholder. Proteggere questi dati è fondamentale.

“Il fine ultimo deve essere proteggere le relazioni con i clienti oltre che ottenere performance migliori – ha detto Luca Boselli, Partner di KPMG -. Dall’indagine “Cyber Trust Insights 2022” effettuata da KPMG a livello internazionale, chi gestisce bene il trust ottiene anche performance migliori. È importante oggi per il CISO trovare alleati nell’organizzazione, da solo può fare ben poco: è importante avere il commitment dei vertici, collegarsi a un ecosistema di soggetti ed evolvere nel suo ruolo, sapersi adattare a trend nuovi come quelli ESG”.

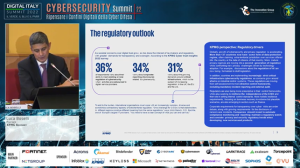

Le norme poi sono numerose e diverse nuove arriveranno, altre anche legate alla digitalizzazione che vanno comunque considerate. “140 nazioni nel mondo hanno una propria norma privacy, e queste legislazioni si sovrappongono – ha aggiunto Luca Boselli -. Siamo al secondo giro del GDPR, che guarda anche alle evoluzioni tecnologiche (pensiamo all’AI): la tendenza è che le norme diventeranno sempre più prescrittive, framework di controlli da applicare sempre in logica risk based. Un altro tema che sta arrivando è l’indipendenza organizzativa e operativa del CISO. Per concludere, sarà sempre più importante automatizzare tutti questi requisiti, avere una visione completa sul panorama delle norme locali e internazionali, considerare tutti gli aspetti che si intrecciano: cyber, privacy, data governance”.

Il tema dell’automazione oggi è centrale: pensando alla migrazione al cloud, le sfide diventano subito velocità e dinamicità, l’user experience è centrale, la sicurezza deve essere garantita in ogni fase.

“Servono processi digitali, un’automazione che non necessariamente richieda grandi investimenti. -ha commentato Nicola Sotira, Responsabile CERT di Poste Italiane -. Sapere quali sono gli asset critici diventa molto importante con questa continua crescita e dinamicità. Postura, rischio, tutto deve muoversi con una velocità comparabile a quella del mondo digitale. Automatizzare aiuta poi molto a ridurre l’errore umano, ad accelerare determinati processi, facilitare e indirizzare le attività. Con riferimento alla formazione delle persone, gli strumenti possono evolvere per aiutare sempre di più gli utenti a non cadere in errore: utile poi fare esercitazioni su più livelli. Sui dipendenti che possono essere coinvolti in vario modo (ad esempio una gara su chi segnala più mail di phishing); sui tecnici, che possono essere abituati a lavorare in caso di incidente con simulazioni di attacco (a individuare dove è l’attacco, comprendere la kill chain, simulare la pressione che c’è durante l’incidente); sul top management, coinvolto con lo scopo di testare la conoscenza delle policy. Individuando in ogni caso i gap, il tutto più volte all’anno”.

Un tema attuale è quello delle soluzioni di Attack Surface Management. Come arrivare prima degli attaccanti, mettendosi dal loro punto di vista? cosa è possibile vedere, come è possibile intervenire?

“Abbiamo da poco lanciato una soluzione che prioritizza le minacce – ha detto Luca Ciucciomini, Senior Sales Team Manager di Darktrace -, offrendo un monitoraggio continuo della superficie di attacco per individuare rischi, vulnerabilità ad alto impatto e minacce esterne. Il tema non è fare assessment ogni trimestre, semestre o una volta l’anno e poi nel resto del tempo rimanere scoperti, ma automaticamente e continuamente, con la potenza di una piattaforma che tutto il giorno prova a capire le esposizioni dell’infrastruttura. Si può così fare una segnalazione a un cliente o bloccare l’utenza di un insider in real time. Avere occhio su movimenti laterali est ovest, vedere anomalie che fanno scattare in automatico un allarme e che arrivano a bloccare le attività indesiderate”.

Il ransomware è oggi la minaccia più temuta, gli attaccanti si stanno dotando di intelligenza artificiale e la catena di attacco è sempre più breve. Negli ultimi anni poi si è aggiunto il fenomeno del doppio o triplo ricatto, con la possibilità di creare danni indiretti a clienti e terze parti. “La sfida è quella di giocare d’anticipo eliminando il ricatto, cercare di anticipare facendo un assessment che sia precedente all’acquisto di tecnologia, specifico sul dominio del ransomware – ha spiegato Vincenzo Calabrò, Adjunct Professor of Cyber Security, Università degli Studi ‘Mediterranea’ di Reggio Calabria -. Individuare dati e asset, classificarli e dare priorità, effettuare operazioni classiche come segmentazione del dato e della rete, rendere più difficile il lavoro all’attaccante, cifrare i dati che rappresentano il valore aziendale. In questo modo abbiamo diminuito l’appetibilità: se lo facessimo tutti scenderebbero gli attacchi nel lungo periodo.

Poi, acquisire strumenti di detection e response, che usano AI, per ridurre la frequenza degli attacchi. Dotarsi anche di strumenti di ripristino, backup sicuri e verificati, questo ci consente di ridurre in modo notevole gli impatti. Concludo con due aspetti spesso trascurati: il fatto di testare, spesso le organizzazioni pensano di aver raggiunto obiettivo con l’adozione della soluzione. Invece i test fanno capire se il rischio è diminuito. E per ultimo condividere l’esperienza dell’attacco. Il fatto di nascondere che l’organizzazione è stata attaccata non fa bene alla comunità”.

Secondo Luca Pesce, Regional Sales Engineer Southern Europe di Exabeam, bisogna partire dal contesto, perché gli incidenti hanno risultati diversi a seconda del contesto impattato. “Il ransomware ha raggiunto capacità distruttive molto elevate, e allo stesso tempo, un attacco di questo tipo può essere realizzato con sempre maggiore semplicità – ha detto Luca Pesce -. Ci sono varianti di ransomware che possono passare le difese, come le vulnerabilità zero-day. Chiunque può essere colpito: come intercettare quindi questi rischi? Riesco ad abbattere gli alert e a dare informazioni rilevanti per prevenire gli attacchi, se adotto soluzioni che effettuano analisi comportamentale, sia lato esseri umani, sia lato macchine. Quest’ultime possono essere utilizzate in modo diverso da quanto previsto proprio quando manipolate dagli attaccanti. Anche nel post-mortem, tramite motori AI è possibile avere playbook e step ben definiti da seguire in modo efficiente, per raggiungere un risultato ben definito”.

Lo scenario in cui oggi ci troviamo a lavorare è particolarmente complesso: il perimetro si è esteso perché si lavora da ovunque, da una molteplicità di device, con politiche multicloud. “Gli attaccanti hanno molte risorse, fanno sempre più spesso ricorso a tecniche avanzate e algoritmi ML, per cui le soluzioni di protezione devono evolvere” è stato il commento di Tristano Ermini, Manager, Systems Engineering di Palo Alto Networks. “L’approccio SASE è nativamente integrato, a differenza di soluzioni puntuali che stanno diventando poco efficienti e poco cost effective. Una soluzione integrata invece può coprire i diversi use case, e puntare ad approcci Zero trust, una filosofia per cui la sicurezza è ridisegnata fin dall’inizio”.

Di conseguenze per la sicurezza nella migrazione al cloud si è parlato nella sessione 5, RISCHI E OPPORTUNITA’ DELLA MIGRAZIONE AL CLOUD.

“Da un po’ di tempo stiamo lavorando sul cloud – ha detto Enrico Maresca, Chief Information Security Officer di Italo – NTV dando il via ai lavori della sessione -, e naturalmente abbiamo visto che il cloud oggi offre molti vantaggi, senza però aiutare in modo particolare a ridurre i costi. Bisogna fare quindi molta attenzione a:

- Non spostare tutto in modo indistinto. Serve pensare bene i processi, prima di spostare le macchine.

- Avere maggior visibilità e controllo. Abbiamo bloccato (come molti altri) l’utilizzo delle chiavette USB e siamo passati a OneDrive, un ambiente più protetto. Possiamo ora avere una maggiore visibilità e un controllo più puntuale su chi accede a cosa, un aspetto che prima, con l’uso di chiavette USB, non era possibile.

- Velocità e scalabilità. Un grande vantaggio con il cloud è la velocizzazione delle attività, sempre dal punto di vista dei processi. Prima serviva mezza giornata per preparare un nuovo computer, ora, con il cloud, un intero parco macchine è pronto in mezz’ora o un’ora.

- Anche aver risolto il tema del patching è un grande vantaggio.

- Servizi innovativi. Ancora: la possibilità di introdurre facilmente soluzioni innovative anche in ambito cybersecurity (passwordless, just-in-time administration, infrastrutture serverless) è un punto di forza importante del cloud.

“Al cloud si accede ovunque, potenzialmente da device diversi – ha commentato Alessandro Gioso, Channel Manager di Forcepoint -. Devo sopperire a questo estendendo la protezione del dato lavorando su parametri diversi, il tenant, le applicazioni e lo storage che utilizzo nel cloud. Un lavoro importante è mettere in sicurezza lo storage: traslare concetti di least privilege, l’uso e il monitoraggio delle applicazioni. Prima però è necessario capire cosa proteggo, di che tipo di dato si tratta, dato storicizzato, di database, che uso ne va fatto e con quale livello di accessibilità: da tutte queste informazioni dipendono le politiche di protezione. Diversamente, rischio di creare ulteriori danni, sia se chiudo un dato che va utilizzato, sia non proteggendo dati da proteggere”.

L’expertise è oggi un problema molto diffuso, un aspetto critico a livello globale, e soprattutto in Italia, dove l’economia dipende per la maggior parte da aziende medio piccole, con staff IT molto ridotto. “Avere il dato in cloud è certamente più sicuro che averlo in casa, ha velocizzato moltissimo i processi per il business, ma la velocità è spesso nemica della sicurezza – ha commentato Vittorio Ranucci, Territory Account Manager di Bitdefender -. In aggiunta oggi molti attacchi avvengono proprio nel cloud. Serve quindi una soluzione che offra prestazioni e facilità d’uso, con servizi gestiti per una detection immediata e una risposta molto veloce per bloccare eventuali attacchi. In più, servizi di Threat Intelligence come i nostri, che sono basati su milioni di sensori nel mondo, tengono monitorati da più fonti i potenziali attacchi, scoprendo in questo modo oltre 200mila minacce al giorno. Analizzando quindi i diversi attacchi potenziali, sono in grado di bloccarli in anticipo. Fondamentale è ridurre i tempi, della detection e della risposta: informazioni qualificate fornite in tempi rapidi aiutano a prevenire le evoluzioni continue delle tecniche di attacco”.

Come ha spiegato Marco Rottigni, Technical Director di SentinelOne, l’utente oggi ha molte superfici attaccabili: identità personale, endpoint, mobile, mondo cloud utilizzato in vari modi. Tutte hanno bisogno di una mitigazione veloce. “È importante capire che gli attacchi oggi lavorano a velocità macchina, non a velocità umana, per cui il tempo di reazione e mitigazione è tempo di resilienza – ha detto Marco Rottigni -. Perché questa garanzia di continuità operativa sia assicurata, bisogna lavorare in autonomia, i sistemi di difesa devono reagire con la stessa velocità con cui accadono gli attacchi. Questo regala all’utente un beneficio immediato, di continuare a lavorare e tornare operativo nell’ordine dei secondi. Oggi poi ogni tecnologia è molto specializzata: il concetto di unire più tecnologie è alla base della strategia XDR. È utile ragionare sull’acronimo XDR: estendere la detection e la risposta, ossia, fornire maggiore contesto nel momento in cui ciascun elemento della catena ha notato qualcosa di strano. Perché non combinare le capacità di più tecnologie per mitigare il rischio a livello molto più ampio? Le security operation riescono così da un lato a d avere più informazioni quando c’è un’anomalia, e riescono a estendere la risposta per mitigare a livello più ampio e per ottenere un livello maggiore di resilienza”.

La sessione 6, intitolata: “IDENTITÀ DIGITALE E INNOVAZIONE ZERO TRUST DEGLI APPROCCI IAM”, ha visto la presenza come moderatrice di Federica Maria Rita Livelli, Membro Comitato Direttivo ANRA, Business Continuity & Risk Management Consultant. “Siamo in un “digital wild west”, tutte le organizzazioni devono adoperarsi per raggiungere la cyber resilience, ma innanzi tutto, come scaturito da questa giornata di lavori, dobbiamo partire dalla conoscenza – ha sottolineato Federica Maria Rita Livelli -. I rischi sono certi, pertanto dobbiamo capire quali sono, misurarli, mitigarli, implementare i principi di cybersecurity per raggiungere una cyber resilience che è responsabilità di tutti, ossia, non è altro che la calibrata sintesi dei principi di risk management, business continuity e cybersecurity”.

Secondo Andrea Guarino, Responsabile Security Awareness & Training, Funzione T&S di Acea, le persone devono oggi essere il punto forte della catena, devono essere formate per esserlo. “Zero Trust è un paradigma per una gestione continua del rischio – ha spiegato Andrea Guarino -. Questo implica una cosa importante: l’analisi del contesto e in particolare dell’identità di chi esegue le azioni, ossia, la capacità di adattarsi dinamicamente al contesto di rischio del processo che stiamo gestendo. Quali sono i punti deboli degli approcci del passato? Capire chi ha fatto cosa, quando, in che contesto, perché, e soprattutto, come. Tutto va contestualizzato correttamente. Dobbiamo avere un costante dubbio sulle identità degli utenti, che va corroborato da prove e indizi, che non sono solo userid e password, anche il comportamento degli utenti. Partecipando al progetto di ricerca Echo, abbiamo evidenziato delle issue fondamentali: dobbiamo saper fare test senza danneggiare persone o processi automatizzati”.

Come fare a provare tutti questi controlli senza danneggiare gli utenti? “Abbiamo portato come Acea queste considerazioni e anche soluzioni nell’ambito di un progetto europeo, Echo, che coinvolge più di 34 aziende e 16 Paesi, e raccolto in diversi Paesi quali sono i problemi. Ci siamo resi conto che una soluzione piuttosto semplice è quella di creare cyber range federati, per cui problematiche di un Paese possono essere rappresentate in altri Paesi o aziende senza replicare il problema, nell’ambito di un consorzio federato, senza inserire queste complessità nei loro ambienti produttivi e di sviluppo. In questo modo, si sedimenta l’idea che la conoscenza condivisa e messa a fattore unico è quella che fa crescere di più”.

Anche secondo Marcello Fausti, Responsabile Cybersecurity di Italiaonline, si può applicare Zero Trust se si è in grado di capire “chi sei” e “che cosa fai”. “Non bisogna trascurare le fondamenta – ha detto Marcello Fausti –: ZTNA è un approccio strategico, che autorizza a fare solo determinate cose, ma seguire un’ondata tecnologica (ad esempio aprendo con il SASE l’accesso da remoto) senza mettere ordine in casa, non diminuisce il livello di rischio. Un approccio che guardi ad autenticazione e autorizzazione delle transazioni, con monitoraggio continuo, deve partire da duro lavoro sui processi. Tante aziende sono frutto di merge: quando due aziende si uniscono, da un momento all’altro si uniscono i servizi di directory, e così il danno è fatto ed è irreversibile. A quel punto è necessario ripartire da zero. Un approccio ZTNA non si fa con una ulteriore “mano di tecnologia” passata sopra l’ultimo livello, bisogna invece lavorare sui processi, avere il coinvolgimento e la collaborazione di tutta l’azienda. La security deve chiaramente avere un ruolo di leadership. Senza un’infrastruttura di accesso con giusti livelli di segregazione, directory ben organizzato con ruoli e profili definiti puntualmente, con user, permission e device che accedono, non si può mettere in campo un approccio Zero trust”.

“Ad oggi abbiamo da un lato la necessità di identificare l’utente, dall’altro lato dobbiamo permettergli di fare quanto necessario – ha commentato Davide Minieri, Head of Sales di Keyless -. Confrontandoci con i clienti, il punto principale è avere la certezza che l’utente sia chi dice di essere. Vediamo sempre di più che l’identificazione certa, legata alla sua credenziale pubblica, è mandataria. Serve avere un link tra la persona e un metodo di autenticazione forte: per il futuro, il perimetro dell’azienda sarà sempre più lasco, e di conseguenza, per dare massima libertà di movimento alle persone, sarà necessario rafforzare l’identità digitale. Quello che cerchiamo di fare è autenticare in modo certo l’utente, a prescindere dal contesto e dall’architettura intorno”.

Zero Trust aiuta ad ottenere una migliore postura di sicurezza. “L’identità digitale oggi pesa molto nella catena di attacco, quindi nell’approcciare questo tema, dobbiamo ragionare sulla riduzione della superficie attaccabile – ha detto Patrizio Rinaldi, Head of Security Tech Specialists di Microsoft Italia -. Per farlo, si deve ragionare quindi in termini di consolidamento: se riesco nella mia infrastruttura a identificare la directory che potrà servire tutti i servizi a corollario, riduco la superfice, mi concentro solo su quello, e in più semplifico la vita agli utenti. La MFA è un fattore determinante, affiancata a strumenti di analisi del comportamento, ma soprattutto dobbiamo far fare all’utente uno scatto in termini culturali. Gli utenti devono capire che il rischio per la loro azienda è molto alta, le conseguenze negative possono impattare le persone. Ciò che avviene nella vita digitale ha influenze dirette nella vita reale, perché le due parti sono coese”.

Infine, la sessione “IL FUTURO DEL SOC NELL’ERA DELL’AI E DEI BIG DATA, COME CAMBIERÀ LA SICUREZZA?” è stata il momento in cui fare il punto su:

- La nuova Threat Intelligence al servizio della Risposta

- SOC evoluto, MSS, MDR, SOC-as-a-service

- Data Protection e nuove frontiere della statistica

“La Threat Intelligence è oggi fondamentale per chi si occupa di sicurezza operativa. Sono informazioni che permettono di prendere decisioni e quindi definire protezioni proattive, o anche reattive nel momento opportuno, se non in tempo macchina, comunque nel modo più veloce possibile – ha detto Vittorio Baiocco, Responsabile Sicurezza ICT e Team SOC di Inail -. Tutto quello che si riesce a prendere da web, dark web, bollettini vari, va trattato in modo automatizzato portando questi dati sugli strumenti di sicurezza. Abbiamo realizzato anche script che estraggono IoC o hash malevoli e li posizionano nel repository. Tutto con strumenti open source, perché poter condividere con altri è oggi molto importante. Da informazioni nel web oggi riusciamo ad avere la visione di cosa succede sugli asset attaccabili, ma lavoriamo molto anche sul dark web, tramite servizi specializzati. Condividere poi queste informazioni a livello quotidiano è fondamentale per elevare una sicurezza di sistema. Va poi tenuto in conto il fatto che troppi dati riducono la visibilità complessiva: il machine learning può servire, in alcuni casi abbiamo sviluppato noi gli algoritmi, il tema è riuscire a ridurre il lavoro ripetitivo filtrando le informazioni più rilevanti”.

Secondo Denis Cassinerio, Regional Sales Director Southern Europe di Acronis, il panorama delle minacce è sempre più complesso. “Avviamo vissuto un picco del 300% di aumento dei crimini informatici durante la pandemia; un 57% di attacchi non rilevati da antivirus tradizionali: un 69% di tempo in più dedicato alla difesa dalle minacce – ha detto Denis Cassinerio -. Con riferimento al mercato dei servizi di SOC, il termine è stato abusato negli ultimi anni, non tutti si rendono conto della complessità nell’erogazione di questi servizi, dei costi e competenze necessarie. Oggi le realtà che li possono erogare non sono tantissime, la democratizzazione dei servizi SOC non c’è stata di fatto in Italia”.

Sempre con riferimento al mercato dei servizi di SOC, c’è una complessità architetturale nella predisposizione di questi servizi. Sorgenti open source, fonti OSINT possono aiutare gli operatori di servizi SOC, ma non sono sufficienti. “La complessità è nemica dello sviluppo di SOC – ha aggiunto Denis Cassinerio -, noi abbiamo puntato ad aiutare questi operatori aggiungendo funzioni e dati alla nostra piattaforma. Aiutiamo anche a lavorare sul reskilling delle persone nella filiera dei servizi di cybersecurity, ad abilitare processi end-to-end dalla prevenzione al ripristino e all’analisi forense, per democratizzare questi approcci”.

Un altro tema molto dibattuto oggi è la sovranità tecnologica. “Questa è la capacità di uno Stato di identificare le tecnologie che sono fondamentali per il suo sviluppo e per la sua competitività a livello internazionale, e la capacità di ottenerle senza dipendere da un’unica fonte o area – ha detto Cassinerio -. Parlare di produzione nazionale di tecnologia, è un concetto utopico e difficilmente realizzabile. Le aziende che operano nel mercato della cybersecurity contribuiscono al mantenimento dell’evoluzione tecnologica. Produrre tecnologie di carattere nazionale si scontra con la realtà architetturale dell’informatica e con il fatto che già oggi utilizziamo tecnologie che vanno oltre i confini nazionali. Bisogna comprendere che nell’ambito della cybersecurity ci sono oggi molte aziende, almeno 3.500 a livello internazionale, e questo sicuramente grazie a capitali privati”.

Quale sarà nei prossimi anni l’evoluzione del SOC e il nuovo ruolo del SOC analyst?

“Il nostro focus è far evolvere il SOC, che in Sogei è stato sviluppato da anni; quindi, doveva evolvere cambiando i processi e crescendo in qualità – ha detto Giovanni Ciminari, Head of Cyber Defence di Sogei. Quello su cui stiamo lavorando è far crescere – sia con risorse interne sia esterne – la figura del SOC analyst, che sempre più dovrà conoscere il business e quindi capire a cosa fa riferimento e come va gestito un segnale debole che esce da una correlazione. Nel mercato esterno oggi questa figura è molto richiesta. Per noi deve anche avere la capacità di progettare strumenti integrati e saperli operare in modo efficace. Un tema molto importante poi è quello della standardizzazione. E il framework Mitre Attack, oltre a creare standard per gli incidenti di sicurezza, fornisce ai nuovi assunti una kill chain a cui far attenzione nella loro attività. Un altro tema è quello delle norme, che stanno cambiando molto. Questo ci proietta come Paese verso un futuro che ora potrebbe realizzarsi”.

Secondo Aldo Di Mattia, Senior Manager Systems Engineering centro/sud Italia di Fortinet il machine learning è già oggi consolidato nella cybersecurity, produce i vantaggi sperati di ridurre i falsi positivi e aumentare il catch rate. “Utilizzare l’AI serve a pareggiare i conti con gli attaccanti, aumenta la produttività – ha detto Aldo Di Mattia -. Questi algoritmi sono fondamentali, ad esempio, nel web application firewall: per difendere un applicativo bisogna capirlo, e questo è molto difficile. Il ML evita questa discussione perché studia e capisce come funziona l’applicativo e come dialoga con i client, attuando misure di sicurezza prima inapplicabili. La soluzione NDR (network detection and response), introdotta di recente nel mercato della cybersecurity, di fatto una sonda sulla rete, in Fortinet è dotata di deep neural network, per un funzionamento veloce nel fare i calcoli. Tutte queste soluzioni però non bastano: oggi si producono centinaia di migliaia di eventi al giorno, quando una persona riesce a gestire pochi incidenti in una settimana. Bisogna riuscire ad elaborare tutti questi dati. Servono quindi servizi di intelligence: nel nostro caso, abbiamo hacker etici che si infiltrano nel dark web e riportano ai clienti le informazioni che trovano, ad esempio, scoprendo in anticipo un eventuale data breach, o informazioni che possono aiutare a individuare un attacco mirato in corso”.

Di cybersecurity-as-a-service ha parlato invece Giovanni Giovannelli, Senior Sales Engineer di Sophos Italia. “Il concetto del cybersecurity-as-a-service è quello di un’economia di scala, poter dare competenza alle persone interne che si occupano di sicurezza, competenze che internamente non si riesce a sviluppare, per mancanza di tempo e difficoltà a tenersi aggiornati – ha detto Giovanni Giovannelli -. Questi servizi aiutano a integrare quanto esiste già, soluzioni e processi in essere, che rimangono, integrandosi per poter ottenere le informazioni utili. Importante anche la flessibilità, i diversi livelli di interazione, oltre che i vari livelli di incident response. Parliamo quindi di servizi MDR, che nel nostro caso integrano le soluzioni in essere. I nostri team sono composti da 500 persone in 6 centri a livello mondiale, con competenze molto diversificate. Scalabilità significa poter fornire questi servizi a tutti, da chi ha un SOC interno, e vuole aumentare il livello di gestione degli attacchi, fino anche alle PMI. Nella flessibilità dell’approccio è compreso anche il fatto che nostri partner system integrator possono interfacciarsi alle aziende o realizzare essi stessi servizi gestiti di sicurezza”.

Aderire alle norme è fondamentale perché la sicurezza nel trattamento dei dati, oltre che essere strumento di accountability, è anche oggetto di uno specifico articolo del regolamento GDPR (Articolo 32 specifico sulla sicurezza del trattamento dei dati personali). “Bisogna superare la logica basata sulle misure minime di sicurezza, guardando invece a tutto il contorno per comprendere quali saranno le misure adeguate: si chiede al titolare un’assunzione di responsabilità – ha commentato Cecilia Colasanti, Data Protection Officer di Istat -. Parlando di statistica ufficiale, oggi, alle tradizionali fonti di dati e tradizionali metodi, oggi abbiamo nuove fonti Big data. Nel regolamento GDPR si fa riferimento ai trattamenti automatizzati, per ribadire la centralità dei diritti degli interessati, che possono ottenere l’intervento umano e anche contestare una decisione che origini da trattamenti automatizzati. Ricordiamoci però che non è l’algoritmo o la macchina a prendere decisioni ma l’uomo che li programma. Quindi serve un monitoraggio attento sugli effetti che le macchine producono. Bisogna sottolineare il fatto che gli algoritmi operano al 99% in modo più corretto dell’uomo, ma questo non vuol dire più giusto”.

Di efficacia della detection e necessità di far evolvere il SOC ha poi parlato Davide Licciardello, Regional Sales Director di Cybereason. “Oggi le misure cardine sono per i gestori di SOC sono l’MTTD (mean time to detect) e l’MTTR (mean time to respond), indicatori da ridurre il più possibile. Dall’esperienza che stiamo raccogliendo, tramite nostri SOC e per bocca di clienti e MSP provider, sfugge a queste metriche l’efficacia della detection – ha detto Davide Licciardello -. Il “Dwell time” è il tempo che intercorre tra l’infiltrazione dell’attaccante e l’identificazione da parte di analisti del SOC: è un tempo che spazia moltissimo, si parla di giorni, settimane, in alcuni casi mesi o anni. Come sfida tecnologica è questa la finestra temporale che stiamo cercando di ridurre. Secondo una statistica recente, intervistando Soc analyst, la conclusione è che in media gestiscono 11mila allarmi al giorno, con 45 tool diversi in media, integrati con l’obiettivo di semplificare la detection, 480 eventi sofisticati in triage, un incidente gestito dall’analista al giorno.

Di questa mole di allarmi la metà sono falsi positivi (quindi una gran perdita di tempo ed efficienza), e un 30% passa non gestito, e lì si può nascondere l’attaccante. Importante allora capire il prima possibile il percorso dell’attacco. Viene quindi in aiuto l’Indicatore di comportamento, che è una nuova definizione, non utilizza solo IoC e prova a predire il percorso che l’attaccante va a fare. Con questo approccio – applicato largamente in NG EDR – si riesce a intercettare anche minacce sofisticate, come gli attacchi che non sfruttano né codice malevolo né zero day ma concatenano strumenti di amministrazione legittimi compromettendo la macchina. L’XDR è un next step: l’EDR è un controllo necessario, l’XDR colma un gap, ossia quanto è efficace la mia correlazione sul SIEM o il mio playbook su SOAR. Il SIEM per quanto ben mantenuto lavora su correlazioni statiche, con correlazioni note. Se l’attaccante cambia due o tre tecniche mi ritrovo da capo. SOAR porta automazione nei playbook di catene note. E oggi molti (la metà secondo le statistiche più recenti) una volta implementati i playbook non li modificano più. XDR è la risposta a questi silos operativi, con il vantaggio di avere l’analista al centro”.

Rivedi la registrazione del pomeriggio del Cybersecurity Summit 2022, lo scorso 18 ottobre a Roma: